4月15日,李飞飞领导的斯坦福大学以人为本人工智能研究院(HAI)发布2024年度《人工智能指数报告》。

这是《人工智能指数报告》的第七年。过去一年,以ChatGPT为代表的人工智能模型席卷世界,许多人预测,人工智能的“奇点时刻”正在临近,机器超越人类的时代已经来临。

这份报告涵盖了过去一年人工智能的技术进步、公众对该技术的看法以及其未来的发展趋势。它是技术飞速发展下的一个注脚,帮助我们理解当下正在发生的变化,以更好地理解我们所处的环境。

作 者:李飞飞 (DR. FEI-FEI LI)斯坦福大学以人为本人工智能研究院(HAI)联合院长

1、人工智能发展的十个事实

1. 人工智能在某些任务上超越了人类,但它需要追赶的地方还有很多

在图像分类、视觉识别和语言理解等领域,人工智能已经超越了人类的能力。然而,在竞赛数学、视觉理解和规划等更复杂的任务上,人工智能仍在追赶人类。

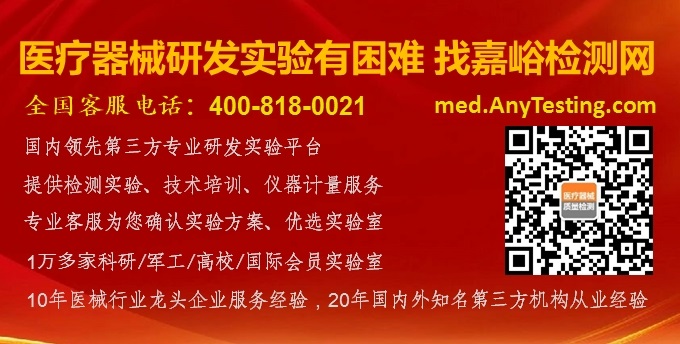

2. 美国仍处于领先地位,但中国已经成为最大的人工智能专利来源国

2023年,美国发布了61个值得关注的机器学习模型,欧盟和中国分别是21个和15个。但值得关注的是,中国已经在2022年以61.1%的份额成为全球人工智能专利最大来源国,美国人工智能专利份额则从2010 年的54.1%下降至2022年的20.9%。

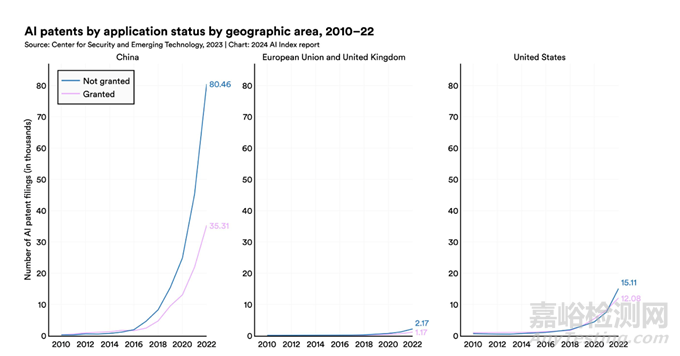

3. 产业界仍在主导人工智能的前沿研究,进一步推动了相关人才从学术届转移

2023年,产业界发布了51个值得关注的机器学习模型,而学术界仅贡献了15个。缺乏算力的学术界在当下人工智能的发展上仍然处于劣势,推动了相关人才从学术届向产业界转移。2019年,美国和加拿大新增加的人工智能领域教师有13%来自产业界。到2021年,这一数字已下降至11%,2022年进一步下降至7%。

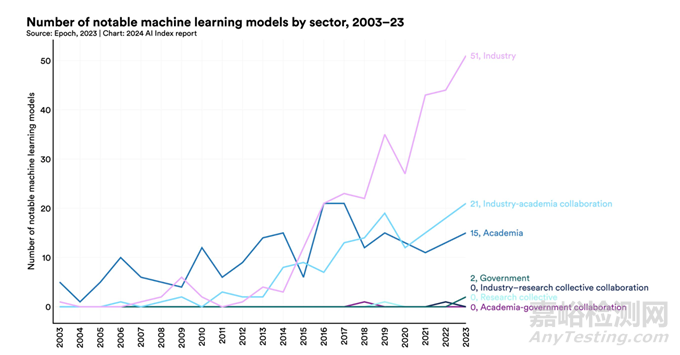

4. 人工智能模型研究变得更加昂贵

OpenAI的GPT-4训练成本高达7800万美元,而Google的Gemini Ultra更是达到了惊人的1.91亿美元。

5. 类似于ChatGPT的大语言生成模型仍然缺乏完善的伦理及风险评估

由于不同模型的测试基准并不相同,使得评估人工智能模型的偏见和伦理问题变得更加复杂。

随着生成模型开始可以生成高质量的文本、图像等,人工智能的基准测试已慢慢开始纳入人工评估(如Chatbot Arena排行榜),而不是单纯的计算机化排名(如ImageNet)。公众对人工智能的感受正在成为追踪人工智能进展的一个越来越重要的考虑因素。

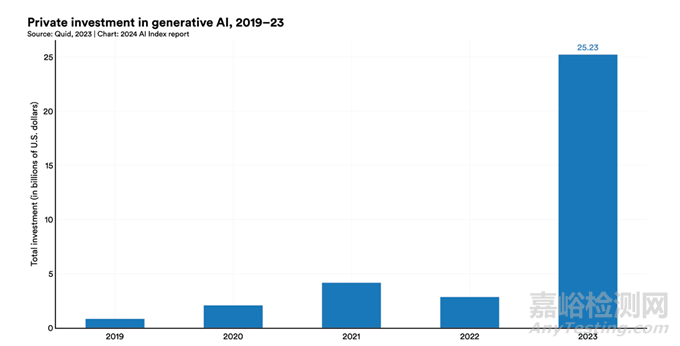

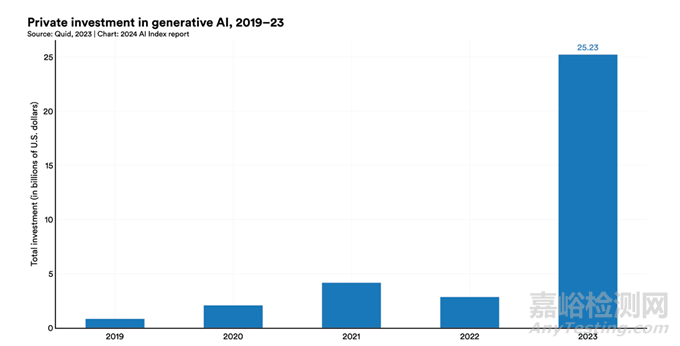

6. 生成式人工智能的投资过去一年增长了近8倍

生成式人工智能的领域资金比2022年增长了近八倍,达到252亿美元。

7. 人工智能提高了劳动者的工作效率,产出的质量也变得更高

多项研究表明人工智能使劳动者能够以更快地速度完成任务并提高产出质量,还可以帮助弥合低技能劳动者和高技能劳动者之间的技能差距。但有研究警告称,在没有适当监督的情况下使用人工智能可能会导致劳动者的工作水平下降。

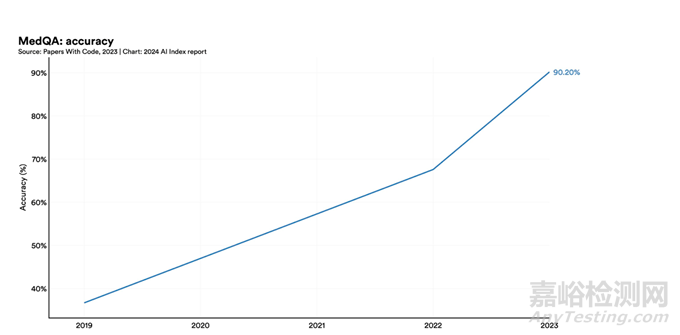

8. 人工智能帮助医学研究取得了突破性进展

过去几年,人工智能在MedQA(医学文本问答数据集)基准上表现出了显著的进步,这是评估人工智能临床知识的关键测试。GPT-4 Medprompt的准确率达到了90.2%,比2022年的最高分提高了22.6 个百分点。自2019年推出该基准测试以来,人工智能的准确性几乎增加了两倍。

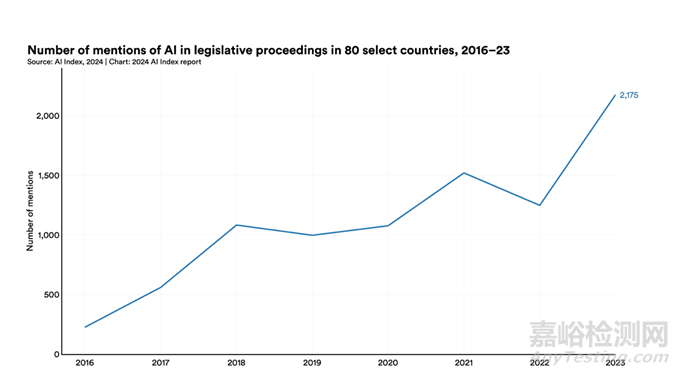

9. 人工智能领域的法规数量急剧增加

2023年,美国人工智能相关法规数达到了25个,而2016年仅有1个。全球各国的法律法规提及人工智能的次数从2022年的1247次增加到2023年的2175次,几乎翻了一番。

10. 人们意识到人工智能正在产生的影响,对这项技术的发展也更加谨慎

益普索(Ipsos)的一项调查显示,去年,认为人工智能将在未来三到五年内极大影响他们生活的人比例从60%上升到66%。此外,52%的人表示对人工智能产品和服务感到焦虑,比2022年上升了13个百分点。皮尤研究中心的数据显示,52%的美国人表示对人工智能感到担忧,这一比例高于2022年的38%。

值得关注的是,年轻一代普遍对人工智能技术的发展更为乐观。59% 的Z世代受访者认为人工智能将改善人类的生活质量,而美国婴儿潮一代的这一比例仅为40%。此外,与低收入和受教育程度较低的人相比,收入和教育水平较高的人对人工智能的发展更加乐观。

2、人是核心

2022年底,ChatGPT的公开发布席卷了世界,随后出现了更多生成式人工智能工具。

从最初只能执行简单的任务到如今具备类似人类的能力,短短几年的时间,人工智能的发展速度令人咋舌,与此同时,人们对其潜在风险的担忧也日益增加。

事实上,人工智能存在的偏见问题直到现在依然没有被很好地解决。

2023年底,《华盛顿邮报》发表了一篇详尽的专题报道,深入探讨了机器学习技术中潜在的偏见。当前的AI图像生成模型,如Dall-E和 Stable Diffusion,有时仍会反映出社会的刻板印象。

例如,在生成“具有创造力的人”的图像时,这些系统往往倾向于呈现白人形象;而在描绘“社会服务人员”时,则多数情况下展示的是有色人种的形象。

其实,大型语言模型,即使是多模态的大型语言模型,可能也并不具备真正意义上的“思考”能力。大型语言模型很容易出现荒谬的概念性失误,也乐于编造听起来合理但实际上毫无意义的胡言乱语。

了解这些事实有助于我们避免过分迷恋模型的能力。然而,随着大型语言模型生成的文本、图像、语音和视频越来越复杂,真与假之间的界限愈加模糊。作为个人、机构,甚至社会,我们究竟有没有能力区分真实和虚构?

我们仍身处一场全球风暴之中,每天似乎都有新的头条新闻报道人工智能对全球劳动者构成的威胁。

随着人工智能在监控领域的应用日趋成熟,记者和人权活动家的担忧与日俱增,对隐私和个人尊严的古老威胁也在现代社会出现,相关报道使公众对人工智能形成了负面看法,这在整个科技领域都是非常罕见的。

科技不断发展,算法语言表达的高级程度已逼近人类水平。机器人正在逐渐学会应对真实的环境。视觉模型不仅可以通过照片进行训练,还可以在全三维世界中进行沉浸式实时训练。

人工智能能够像识别内容一样流畅地生成内容。与此同时,伦理问题在我们周围不断涌现,与人类经济社会发展的关联也日益紧密,但这就是科学一直以来的样子。

3、未来会怎样?

人工智能曾经是纯粹的科学,而现在,我们更愿意用:“现象”“颠覆”“谜题”“特权”“自然之力”来定义新一代人工智能所能做的一切,无论是好是坏,无论是在预期之内,还是在意料之外,都因其设计本身缺乏透明度而变得复杂。

如果在算法设计完成后,再加入安全性和透明度等考虑因素,无论设计得多么精妙,都不足以满足要求。下一代人工智能必须从开发之初就采取与现在完全不同的理念。以激情为起点固然很好,但我们要面对的是纷繁复杂而又不起眼的挑战,要取得真正的进展,就必须有敬畏之心。而硅谷似乎缺乏这种心态。

如今,人工智能是一种责任,是我们所有人共同承担的责任。

深度学习飞速发展,每一年都感觉像是要面对一个全新的领域,其应用的深度和多样性增长得如此之快,甚至全职研究生和博士后也很难跟上文献的步伐,更不用说教授们了。可能性无穷无尽,挑战也永无止境。

即使在这样一个黑暗的时代,人工智能也具有无与伦比的激励力量。面对全球亟待解决的问题,面对具有历史意义的机遇,面对可能需要几代人的努力才能揭开谜底的未知,真正解决所有问题的答案远远不是公司战略或学术课程所能提供的。

未来几年,从业者需要的不仅是专业技术知识,他们还必须了解哲学、伦理学,甚至法律。

想象空间是巨大的,但愿景需要一个重要的纽带串联起来,这个纽带就是大学。早在有人利用人工智能谋取利益之前,人工智能就已经在大学里起步了。在大学校园里,仍然最有可能感受到某些意想不到的研究突破带来的火花。感知机、神经网络、ImageNet,以及后来的很多东西都出自大学。

要从根本上重新构想人工智能,使其成为以人为本的实践,与其说这是旅程方向的改变,不如说是旅程范围的扩展。人工智能一直以来都追求科学性,而现在,它必须也追求人性。

人工智能应该秉承最优秀的学术传统,保持合作和敬畏,同时不惧怕直面现实世界。毕竟,星光是多样的。一旦白色的光辉展开,各种颜色就会发出耀眼夺目的光芒。